Искусственный интеллект достиг пика своей популярности. В СМИ мелькают новости то о том, как в некоторых компаниях IBM Watson заменяет собой живых сотрудников, то о том, как алгоритмы превосходят врачей при постановке диагноза. Каждый день появляются новые стартапы, претендующие на решение всех ваших личных и деловых проблем с помощью машинного обучения.

Обычные предметы, типа соковыжималок и Wi-Fi роутеров, вдруг стали позиционироваться как «наделенные искусственным интеллектом». Умные столы запоминают настройки высоты столешниц и заказывают обед через интернет.

Большая часть этого хаоса дело рук журналистов, которые никогда не имели дела с нейронной сетью и ее обучением, а также стартапов, которые пытаются набрать на работу инженерные кадры, не решив при этом более общие проблемы бизнеса. Неудивительно, что существует такое множество неверных представлений о том, что может и чего не может сделать ИИ.

Глубинное обучение — это, конечно, нечто из ряда вон

Нейронные сети были изобретены в 60-х годах, но недавние достижения в области больших данных и вычислительной мощности сделали их действительно полезными. Возникла новая дисциплина под названием «глубинное обучение», которая может использовать более сложные, чем раньше, конструкции нейронных сетей для моделирования данных.

Результаты, бесспорно, впечатляют. Компьютеры теперь могут распознавать объекты на фото и видео, а также преобразовывать речь в текст лучше и быстрее, чем люди. Google Translate теперь работает на основе нейронных сетей, и результат машинного перевода стал более «человеческим».

Применение на практике также выше всяких ожиданий. Компьютеры стали прогнозировать урожайность лучше, чем Министерство сельского хозяйства, а диагностировать рак более точно, чем опытные врачи.

Джон Лаунчбери, директор DARPA, описывает три волны искусственного интеллекта:

1. Вручную управляемые базы знаний или экспертные системы, такие IBM Deep Blue или Watson

2. Статистическое натаскивание, включающее машинное и глубинное обучение

3. Контекстная адаптация, которая включает в себя построение надежных, ясных моделей для явлений реального мира с использованием разрозненных данных тем способом, как это делают люди

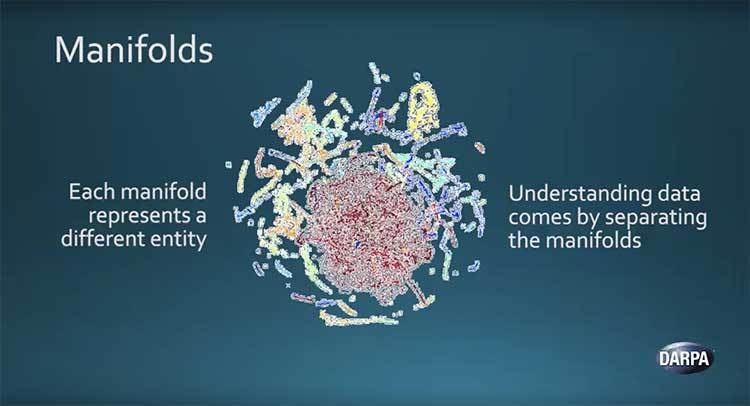

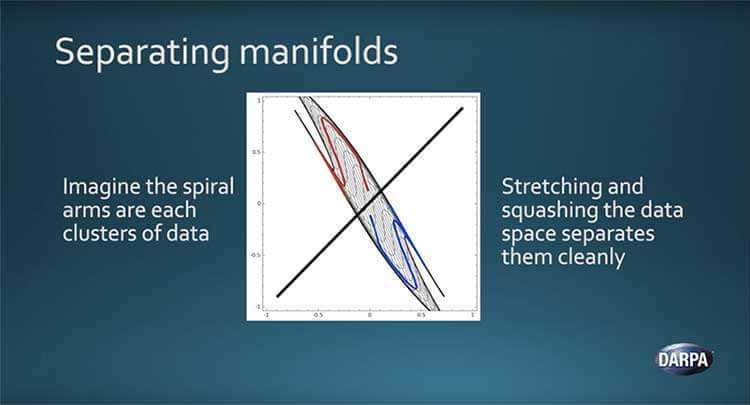

В рамках нынешней второй волны искусственного интеллекта глубинные алгоритмы обучения хорошо работают из-за того, что Лаунчбери называет «многогранной гипотезой» (см. ниже). В упрощенном виде это можно представить в виде различных типов полноразмерных естественных данных, имеющих тенденцию к фильтрации и разделению по общему признаку.

Математически обрабатывая и разделяя данные, глубинные нейронные сети могут различать разные типы данных. Нейронные сети могут достичь тонкой классификации и возможностей предикации, они по существу являются тем, что Лаунчбери называет «табличным процессором на стероидах».

У глубинного обучения и проблемы глубинные

На недавней конференции AI By The Bay Франсуа Чолле подчеркнул, что глубинное обучение — это просто более мощное распознавание образов, чем предыдущие методы статистического и машинного обучения. «Самая важная проблема для ИИ сегодня — это абстракция и рассуждения», — объясняет Чолле, исследователь ИИ в Google, и знаменитый изобретатель широко используемой библиотеки глубинного обучения Keras . «Современные контролируемые алгоритмы восприятия и закрепления требуют большого количества данных, являются ужасными при планировании и осуществляют лишь прямое распознавание образов».

Напротив, люди «учась на очень ограниченных примерах, могут осуществлять весьма долгосрочное планирование и способны формировать абстрактные модели ситуации и [манипулировать] этими моделями для достижения крайнего обобщения».

Даже примеры простого человеческого поведения трудоемки для адаптации к алгоритмам глубинного обучения. Давайте рассмотрим ситуацию, когда нужно избежать столкновения с автомобилем, когда вы идете по дороге. Если вы идете по контролируемому обучающему маршруту, вам потребуются огромные массивы данных с ситуациями вокруг автомобиля с четко обозначенными действиями, такими как «остановка» или «движение». Затем вам нужно будет обучить нейронную сеть, чтобы определить соответствие между обстоятельствами и соответствующими действиями.

Если вы проведете курс обучения, где зададите алгоритму цель и позволите ему самостоятельно определять идеальные действия, которые нужно предпринять, компьютеру придется умереть тысячи раз, прежде чем он научиться избегать автомобилей в разных ситуациях.

«Вам не удастся добиться интеллекта путем простого расширения современных методов обучения», — предупреждает Холле.

Людям достаточно лишь однажды сказать, чтобы они избегали автомобилей. Мы обладаем способностью обобщать несколько примеров и способны представить себе (то есть моделировать) ужасные последствия наезда. Не теряя ни жизни, ни конечностей, большинство из нас быстро научится избегать встречи с автомашинами.

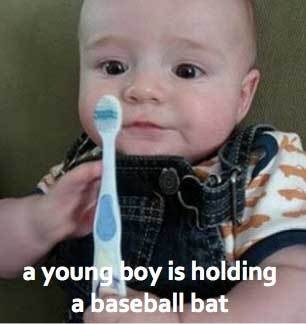

Хотя нейронные сети достигают впечатляющих результатов оперируя большими наборами данных, они «индивидуально ненадежны» и часто совершают ошибки, которые люди никогда бы не сделали, например, могут распознать зубную щетку как бейсбольную биту.

Ваши результаты хороши настолько, насколько хороши ваши исходные данные. Нейронные сети, получающие неточные или неполные данные, будут давать неправильные результаты. Результаты могут быть как курьезными, так и летальными. В двух крупных PR-провалах Google Images неправильно классифицировали афроамериканцев как горилл, а Tay от Microsoft стал изрекать расистские, женоненавистнические перлы уже после часа обучения в Twitter.

Существует риск наличия нежелательных отклонений в исходных данных. Массив Word2Vec от Google составлен из 3 миллионов слов из новостей Google. В массиве содержится и такая сентенция, как «отец должен быть врачом, мать — санитаркой», которая отражает гендерную предвзятость в обществе. Исследователи, такие как Толга Болукбаши из Бостонского университета, взялись вручную исправить подобную тенденциозность в Mechanical Turk, чтобы исключить подобные ассоциации.

Такая тактика важна, поскольку, по словам Болукбаши, «слова не только отражают стереотипы, но также могут усиливать их». Если термин «врач» больше ассоциируется с мужчинами, чем с женщинами, тогда при замещении вакансии врача алгоритм может отдать предпочтение кандидатам-мужчинам.

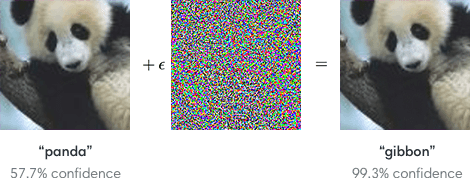

Ян Гудфеллоу, первооткрыватель генеративных состязательных сетей (GAN), показал, что нейронные сети можно умышленно ввести в заблуждение состязательными примерами. Математически манипулируя изображением таким образом, чтобы его нельзя было обнаружить человеческим глазом, изощренные злоумышленники могут обмануть нейронные сети.

Что находится за пределами глубокого изучения?

Как мы можем преодолеть ограничения глубинного обучения и перейти непосредственно к искусственному интеллекту? Первоначальный план атаки Холле предполагает использование «суперчеловеческого распознавания образов, подобного глубинному обучению, для увеличения явного поиска и формальных систем», начиная с области математических доказательств. Автоматизированные тестеры теорем (ATP) обычно используют грубый поиск и на практике быстро становятся бесполезны. В проекте DeepMath Холле и его коллеги использовали глубинное обучение, чтобы помочь процессу поиска доказательств, имитируя математическую интуицию при определении того, какие из лемм (вспомогательная или промежуточная теорема в аргументе или доказательстве) могут быть релевантны.

Другой подход заключается в разработке более понятных моделей. При распознавании рукописного текста в настоящее время нейронные сети необходимо обучить десяткам и сотням тысяч примеров для осуществления достойной классификации. Однако вместо того, чтобы рассматривать только пиксели, Лаунчбери из DARPA объясняет, что генеративные модели могут запоминать образы любых заданных знаков и использовать информацию, описывающую физическую конструкцию, для устранения неоднозначности между одинаковыми числами, такими как 9 или 4.

Янн ЛеКан, изобретатель сверточных нейронных сетей (CNN) и руководитель исследований ИИ в Facebook, предлагает «энергетические модели» как метод преодоления ограничений в глубинном обучении. Как правило, нейронная сеть обучается генерировать единый вывод, такой как распознавание изображения или перевод предложения. Вместо этого энергетические модели ЛеКана предоставляют целый набор возможных результатов, таких как множество способов перевода предложения, а также систему оценок для каждой конфигурации.

Джеффри Хинтон, широко известный как «отец глубинного обучения», хочет заменить нейроны в нейронных сетях на «капсулы», которые, по его мнению, более точно отражают структуру коры человеческого мозга. «Эволюция, должно быть, нашла эффективный способ адаптировать функции восприятия, существовавшие на ранних этапах, сделав их более полезными на поздних этапах развития», объясняет Хинтон. Он надеется, что основанные на капсулах нейронные сетевые архитектуры будут более устойчивы к состязательным атакам, которые Гудфеллоу описывал выше.

Возможно, все эти подходы к преодолению пределов глубокого обучения по-настоящему ценны. Возможно, ничто из этого не стоит внимания. Только время и дальнейшие инвестиции в исследования ИИ дадут ответ.